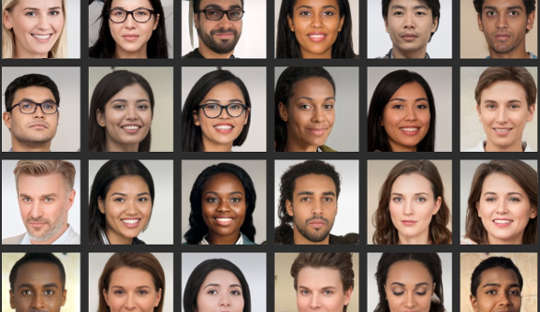

Incluso si crees que eres bueno analizando caras, investigación muestra muchas personas no pueden distinguir de manera confiable entre fotos de rostros reales e imágenes generadas por computadora. Esto es particularmente problemático ahora que los sistemas informáticos pueden crear fotografías de aspecto realista de personas que no existen.

Recientemente, un perfil falso de LinkedIn con una foto de perfil generada por computadora fue noticia porque conectado exitosamente con funcionarios estadounidenses y otras personas influyentes en la plataforma de networking, por ejemplo. Los expertos en contrainteligencia incluso dicen que los espías crean rutinariamente perfiles fantasmas con tales imágenes para dirigirse a objetivos extranjeros a través de las redes sociales.

Estas falsificaciones profundas se están generalizando en la cultura cotidiana, lo que significa que las personas deberían ser más conscientes de cómo se utilizan en marketing, publicidad y redes sociales. Las imágenes también se utilizan con fines maliciosos, como propaganda política, espionaje y guerra de información.

Hacerlos implica algo llamado red neuronal profunda, un sistema informático que imita la forma en que aprende el cerebro. Esto se "entrena" al exponerlo a conjuntos de datos cada vez más grandes de rostros reales.

De hecho, dos redes neuronales profundas se enfrentan entre sí, compitiendo para producir las imágenes más realistas. Como resultado, los productos finales se denominan imágenes GAN, donde GAN significa Generative Adversarial Networks. El proceso genera imágenes novedosas que son estadísticamente indistinguibles de las imágenes de entrenamiento.

En nuestro estudio publicado en iScience, mostramos que el hecho de no distinguir estos rostros artificiales de los reales tiene implicaciones para nuestro comportamiento en línea. Nuestra investigación sugiere que las imágenes falsas pueden erosionar nuestra confianza en los demás y cambiar profundamente la forma en que nos comunicamos en línea.

Mis colegas y yo descubrimos que las personas percibían los rostros de GAN como incluso más reales que las fotos genuinas de rostros de personas reales. Si bien aún no está claro por qué sucede esto, este hallazgo no destacar los avances recientes en la tecnología utilizado para generar imágenes artificiales.

Y también encontramos un vínculo interesante con el atractivo: las caras que se calificaron como menos atractivas también se calificaron como más reales. Las caras menos atractivas pueden considerarse más típicas y la cara típica puede usarse como referencia contra el cual se evalúan todas las caras. Por lo tanto, estas caras GAN se verían más reales porque son más similares a las plantillas mentales que las personas han construido a partir de la vida cotidiana.

Pero ver estos rostros artificiales como auténticos también puede tener consecuencias para los niveles generales de confianza que brindamos a un círculo de personas desconocidas, un concepto conocido como "confianza social".

A menudo leemos demasiado en los rostros que vemos, y el las primeras impresiones que nos formamos guían nuestras interacciones sociales. En un segundo experimento que formó parte de nuestro último estudio, vimos que era más probable que las personas confiaran en la información transmitida por rostros que previamente habían considerado reales, incluso si se generaron artificialmente.

No es sorprendente que las personas confíen más en las caras que creen que son reales. Pero descubrimos que la confianza se erosionó una vez que se informó a las personas sobre la posible presencia de rostros artificiales en las interacciones en línea. Luego mostraron niveles más bajos de confianza, en general, independientemente de si las caras eran reales o no.

Este resultado podría considerarse útil de alguna manera, porque hizo que las personas sospecharan más en un entorno en el que pueden operar usuarios falsos. Sin embargo, desde otra perspectiva, puede erosionar gradualmente la naturaleza misma de cómo nos comunicamos.

En general, tendemos a operar en una suposición predeterminada de que otras personas son básicamente veraces y confiables. El crecimiento de los perfiles falsos y otros contenidos artificiales en línea plantea la cuestión de hasta qué punto su presencia y nuestro conocimiento sobre ellos pueden alterar este estado de "verdad por defecto", lo que finalmente erosiona la confianza social.

Cambiar nuestros valores predeterminados

La transición a un mundo donde lo que es real es indistinguible de lo que no lo es también podría cambiar el panorama cultural de ser principalmente veraz a ser principalmente artificial y engañoso.

Si regularmente cuestionamos la veracidad de lo que experimentamos en línea, es posible que debamos volver a desplegar nuestro esfuerzo mental desde el procesamiento de los mensajes mismos hasta el procesamiento de la identidad del mensajero. En otras palabras, el uso generalizado de contenido en línea altamente realista, pero artificial, podría obligarnos a pensar de manera diferente, de maneras que no esperábamos.

En psicología, usamos un término llamado "monitoreo de la realidad" para identificar correctamente si algo proviene del mundo externo o de nuestro cerebro. El avance de las tecnologías que pueden producir caras, imágenes y videollamadas falsas, pero altamente realistas, significa que el monitoreo de la realidad debe basarse en información distinta de nuestros propios juicios. También exige una discusión más amplia sobre si la humanidad aún puede permitirse el lujo de optar por la verdad por defecto.

Es crucial que las personas sean más críticas al evaluar las caras digitales. Esto puede incluir el uso de búsquedas de imágenes inversas para verificar si las fotos son genuinas, desconfiar de los perfiles de redes sociales con poca información personal o una gran cantidad de seguidores, y ser consciente del potencial de la tecnología deepfake para ser utilizada con fines nefastos.

La próxima frontera para esta área debería ser algoritmos mejorados para detectar caras digitales falsas. Luego, estos podrían integrarse en las plataformas de redes sociales para ayudarnos a distinguir lo real de lo falso cuando se trata de las caras de las nuevas conexiones.

Sobre el Autor

Manos Tsakiris, Profesor de Psicología, Director del Centro de Políticas de los Sentimientos, Royal Holloway University of London

Este artículo se republica de La conversación bajo una licencia Creative Commons. Leer el articulo original.